La Unión Europea ha aprobado la ley de Inteligencia Artificial por 523 votos a favor y solo 46 en contra. Casi cinco años han pasado desde que se propusiera el primero borrador hasta que, por fin, es una realidad a la espera de la regulación auxiliar que desarrolle parte de sus pretensiones. AI Act, que es su nombre oficial, pase a ser uno de los hitos más importantes del desarrollo de los mercados digitiales de la Unión Europea, y como viene siendo habitual, no lo hace exenta de polémica.

En primer lugar, porque a lo largo de su debate y cambios durante estos cinco años, ha dejado de lado parte de sus principios fundamentales, y por otro, llega justo cuando la Inteligencia Artificial está inmersa en una serie de cambios que la regulación, al menos en su última redacción no termina de desarrollar del todo.

Sea como sea, la aprobación de la Ley de Inteligencia Artificial es una buena noticia para todos. Es la primera gran regulación comunitaria en esta materia que, además, es pionera en el mundo en muchos de sus aspectos, por lo que puede ser un espejo de cara a que otros países pongan en marcha regulaciones similares.

Al igual que muchas de las regulaciones de calado de la Unión Europea, la AI Act también tiene un enfoque pro-ciudadano, y no tanto para la industria. Esto ha sido el driver principal de la normativa, en tanto su núcleo principal tiene como objetivo actuar para proteger la seguridad del consumir, con un enfoque basado en el riesgo de los productos que usan esta tecnología. Porque en realidad, la Ley de Inteligencia Artificial es un solo framework que complementa otra serie de iniciativas europeas, como el AI Innovation Package y el Coordinated Plan on AI.

- CHECALO -

La Ley de Inteligencia Artificial funciona como un sistema de análisis del riesgo

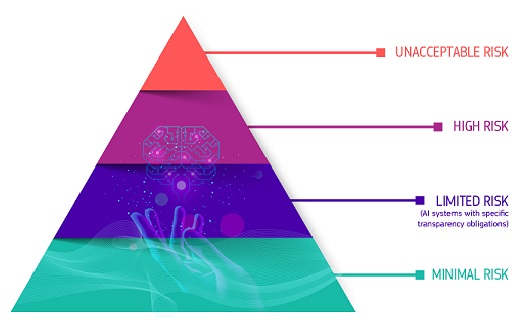

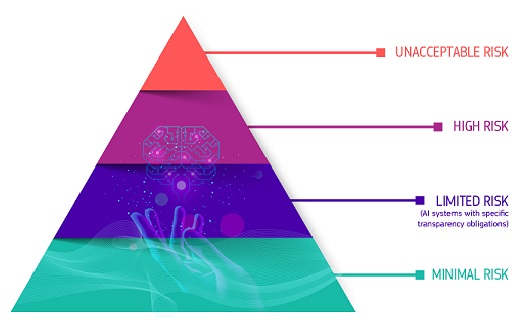

Este es un aspecto importante para entender cómo funciona la IA Act. La nueva normativa funciona como un sistema de gestión de riesgos, planteando 4 niveles diferentes y aplicando una serie de reglas específicas a cada uno de los niveles. Dichos niveles viene determinados por la capacidad de cada IA para tener un impacto en el ciudadano.

Y de forma general, la Ley de Inteligencia Artificial Europea prohíbe todos los sistemas de IA que se consideren una clara amenaza para la seguridad, los medios de vida y los derechos de las personas. Por ejemplo, prohíbe expresamente el uso de IA para generar una «puntuación social» para los gobiernos o juguetes que utilizan asistentes de voz y fomentan comportamientos peligrosos, por considerarse de riesgo inaceptable.

Tambien prohibe de forma expresa los sistemas de categorización biométrica basados en datos sensibles y la extracción de imágenes faciales de Internet o imágenes de CCTV para crear bases de datos de reconocimiento facial. También estarán prohibidos el reconocimiento de emociones en el lugar de trabajo y las escuelas, la vigilancia policial predictiva (cuando se base únicamente en perfilar a una persona o evaluar sus características) y la IA que manipule el comportamiento humano o explote las vulnerabilidades de las personas.

4 niveles de riesgo

En el otro extremo de la pirámide está lo que se denomina riesgo mínimo: por ejemplo, los videojuegos con IA o su uso para filtros de spam. Según la Unión Europea, la gran mayoría de los sistemas de IA que se utilizan actualmente en la UE entran en esta categoría. Cuanto más riesgo tiene una aplicación de IA para el ciudadano, más escrutinio y más reglas se les aplica.

Pero también sirve no solo para proteger los derechos los ciudadanos, sino para brindar una capa extra de seguridad al uso de la IA en infraestructuras vitales de la Unión o en aplicaciones muy específicas. Por ejemplo, la ley considera alto riesgo la utilización de la IA en dispositivos médicos o infraestructuras críticas, como redes de agua o eléctricas. Por ello, aplica muchas limitaciones y requisitos más estrictos, como una documentación detallada con toda la información necesaria sobre el sistema y su propósito para que las autoridades evalúen su cumplimiento y un alto nivel de robustez en materia de seguridad y precisión.

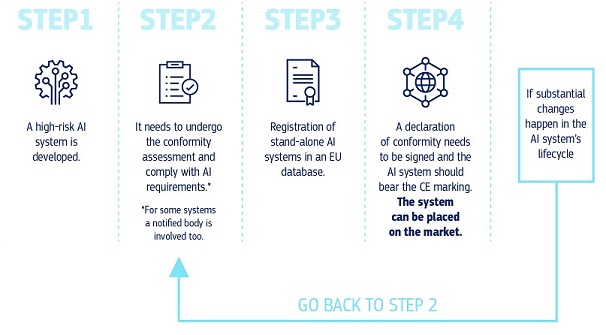

La ley contempla un sistema de verificación y certificación de cada Inteligencia Artificial y su eso. Este es, quizás, uno de los puntos más importantes y a la vez más complejos de definir. Una vez que un sistema de IA quiere al mercado, los implementadores tienen que garantizar su supervisión y el seguimiento humanos. Se comprueba que sea acorde con la normativa y la definición que hace la ley, se registra dentro de sistema de la UE y se libra declaración de conformidad.

Si los tres pasos son positivos, se permite su despliegue en el mercado. Además, esta monitorización es constante en el tiempo: al momento que la IA introduzca cambios significativos, se vuelve al paso dos y se vuelve a poner en marcha el proceso de autorización. Durante paso de aprobación previa, se determina el nivel de riesgo y el impacto de la IA, y se definen los específicos de la normativa que se aplica.

Y sobre uno de los puntos fundamentales de la IA, los propios modelos, la normativa también introduce una serie obligaciones de transparencia. La idea es que el regulador (o el ciudadano) tenga una mejor idea de cómo funciona de estos modelos, además de aplicar una serie obligaciones adicionales de gestión de riesgos para aquellos que sean especialmente potentes y complejos. Estas obligaciones adicionales incluyen la autoevaluación y mitigación de riesgos sistémicos, la notificación de incidentes graves, la realización de evaluaciones de pruebas y modelos o requisitos de ciberseguridad extra que no aplican a otros sistemas de IA más sencillos.

DERECHOS DE AUTOR

Esta información pertenece a su autor original y fue recopilada del sitio https://hipertextual.com/2024/03/ley-de-inteligencia-artificial