Meta presentó una nueva iniciativa que buscará promover el desarrollo seguro de la inteligencia artificial. Conocido como Purple Llama, el proyecto agrupará herramientas y evaluaciones enfocadas a construir modelos de IA generativa de manera responsable. La compañía buscará asociarse con Google, Microsoft, Amazon y otras empresas del sector para mejorar su suite y ofrecerla a la comunidad de desarrolladores.

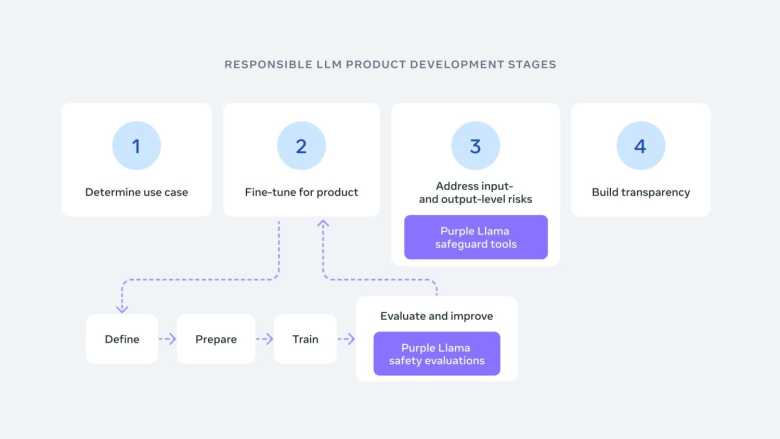

Purple Llama estará basada en la Guía de Uso Responsable de Meta, un documento con buenas prácticas y consideraciones que deben tener los desarrolladores al diseñar productos impulsados por inteligencia artificial. Las herramientas podrán usarse en investigación y en modelos de lenguaje comerciales.

“La colaboración en materia de seguridad generará confianza en los desarrolladores que impulsan esta nueva ola de innovación y requiere investigación y contribuciones adicionales sobre IA responsable”, dijo Meta. “Las personas que construyen sistemas de IA no pueden abordar los desafíos de forma aislada, por lo que queremos nivelar el campo de juego y crear un punto central y abierto para la confianza y la seguridad.”

La primera versión de Purple Llama se enfocará en la seguridad. El proyecto brindará herramientas para abordar los riesgos de los modelos de lenguaje extenso (LLM) en escenarios de ciberataques y generación de código malicioso. Meta también ofrecerá soluciones para detectar contenido potencialmente riesgoso o que infrinja derechos de autor, tanto en entrada como salida.

- CHECALO -

Para este proyecto, Meta ha tomado un enfoque similar al de su inteligencia artificial. La compañía menciona que la colaboración es fundamental para generar un ecosistema abierto. Purple Llama tendrá el soporte de empresas como AMD, AWS, Google Cloud, Dropbox, IBM, Intel, Microsoft, NVIDIA, Oracle y otros más.

El primer fruto de Purple Llama es CyberSec Eval, un conjunto de herramientas para evaluar los riesgos de ciberseguridad en modelos LLM. De acuerdo un documento técnico, es el punto de referencia de seguridad más extenso a la fecha y evalúa la capacidad de un modelo para generar código inseguro, así como su nivel de cumplimiento al pedirle que ayude a realizar ciberataque.

Meta menciona que CyberSec Eval identificó los riesgos de ciberseguridad en modelos como Llama2 o GPT y ofreció consejos para solucionarlos. Los investigadores de la empresa afirman que los modelos avanzados tienden a sugerir código inseguro, por lo que es necesario un proceso de evaluación y refinación.

Otro componente de Purple Llama es Llama Guard, un modelo entrenado para evitar que una inteligencia artificial genere respuestas inapropiadas. Llama Guard está orientado a conversaciones entre un humano y una IA (como ChatGPT) y categoriza los riesgos de entrada y salida. Al efectuar el análisis y descubrir un contenido potencialmente inseguro, los desarrolladores podrán añadirlo a sus filtros para evitar que el modelo lo procese.

El anuncio de Purple Llama se da a unos días de la creación de la IA Alliance, conformada por Meta, IBM y decenas de organizaciones. La alianza busca impulsar el desarrollo de modelos de IA seguros y de código abierto y cuenta con el apoyo de Intel, AMD, NVIDIA y Oracle. También se han sumado la NASA, el CERN, la Fundación Linux y universidades de prestigio a nivel mundial.

DERECHOS DE AUTOR

Esta información pertenece a su autor original y fue recopilada del sitio https://hipertextual.com/2023/12/meta-purple-llama-iniciativa-inteligencia-artificial-segura