Microsoft ha presentado Phi-4-multimodal y Phi-4-mini, los últimos integrantes de su familia Phi de modelos de lenguaje pequeños (SLM). Phi-4-multimodal es el primer modelo de la compañía capaz de procesar simultáneamente habla, visión y texto. La nueva IA del gigante tecnológico se desempeña de forma notable en tareas de reconocimiento de voz o traducción, aunque queda corto en otras pruebas frente a los modelos de la competencia.

De acuerdo con una publicación en la web de Microsoft. Phi-4-multimodal está construido sobre una arquitectura de 5.600 millones de parámetros. El modelo utiliza una mezcla de LoRAs (Low-Rank Adaptations) para integrar diferentes modalidades de entrada en un espacio de representación unificado. Una de las ventajas de usar técnicas de aprendizaje cruzado entre modalidades es que mejora el razonamiento y permite interacciones más contextuales.

Microsoft afirma que su nuevo modelo cuenta con un vocabulario más amplio y soporte multilingüe, mejorando su precisión en el procesamiento del lenguaje. Además, Phi-4-multimodal soporta inferencia de baja latencia, lo que permite ejecutarlo en dispositivos móviles y equipos de gama de entrada.

Según comentan sus desarrolladores, Phi-4-multimodal está diseñado para la eficiencia y escalabilidad, dos términos que se han vuelto populares en los últimos meses. La llegada de DeepSeek y la explosión de modelos pequeños han hecho que desarrolladores consideren los SLM como alternativa ante un LLM. La arquitectura de este nuevo modelo mejora la velocidad y precisión del procesamiento, soportando entradas multilingües e integrando el razonamiento del lenguaje con datos multimodales.

- CHECALO -

Phi-4-multimodal supera a modelos más grandes de Google y Anthropic

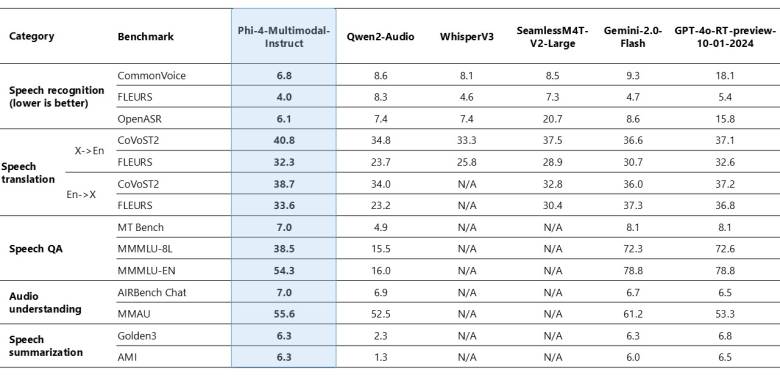

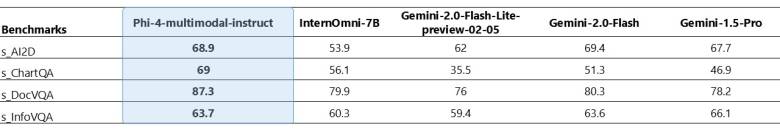

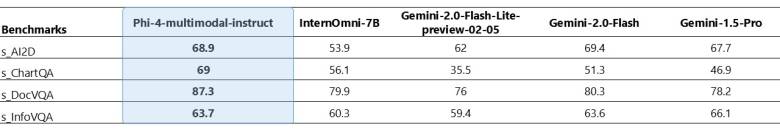

En términos de rendimiento, Phi-4-multimodal supera a modelos especializados como WhisperV3 y SeamlessM4T-v2-Large en pruebas de reconocimiento automático de voz y traducción de voz. El modelo de Microsoft también consigue buenas calificaciones en capacidades de visión, incluyendo Reconocimiento Óptico de Caracteres (OCR), comprensión de documentos y gráficos, así como razonamiento científico visual.

Su arquitectura compacta compite eficazmente con modelos más grandes — como Gemini-2-Flash-lite y Claude-3.5-Sonnet — en capacidades multimodales generales. A pesar de estos logros, Phi-4-multimodal no se desempeña muy bien en tareas de preguntas y respuestas basadas en voz, donde queda rezagado respecto a modelos como Gemini-2.0-Flash y GPT-4o.

Esta brecha se atribuye a su tamaño de modelo más pequeño, que limita su capacidad para retener una cantidad mayor de conocimientos factuales. Microsoft comentó que está trabajando activamente en mejorar esta capacidad en futuras iteraciones.

Junto a Phi-4-multimodal, Microsoft presentó Phi-4-mini, un modelo orientado a tareas basadas en texto. Su arquitectura permite un procesamiento eficiente de entradas de texto sin sacrificar la precisión ni la velocidad, lo que lo convierte en una opción ideal para aplicaciones que requieren comprensión avanzada del lenguaje natural (como chatbots o asistentes virtuales).

Phi-4-multimodal y Phi-4-min están disponibles a partir de hoy en plataformas como Azure AI Foundry, HuggingFace y el Catálogo de API de NVIDIA.

DERECHOS DE AUTOR

Esta información pertenece a su autor original y fue recopilada del sitio https://hipertextual.com/2025/02/microsoft-phi-4-multimodal-modelo-ia-voz-imagenes-texto