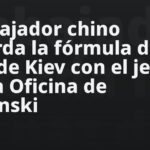

El principio del fin se acerca para los seres humanos. Figure 01, un robot humanoide impulsado por la inteligencia artificial de OpenAI, ha mostrado capacidades de razonamiento visual y comprensión de lenguaje. Apoyándose de redes neuronales, sus creadores consiguieron que ejecutara acciones y respondiera usando una voz sintética.

El robot es obra de Figure, una empresa de inteligencia que busca «ampliar las capacidades humanas» a través de la IA avanzada. La compañía tiene como objetivo «revolucionar la cadena de producción» con robots humanoides capaces de desempeñar trabajos inseguros o indeseables. De este modo, todos tendríamos vidas más felices y con mayor propósito.

Para llegar a ese futuro, Figure ha cerrado un acuerdo con OpenAI para integrar su inteligencia artificial en el Figure 01. Con ello, el robot sería capaz de comprender el lenguaje y actuar en consecuencia, pudiendo integrarse como trabajador en una fábrica.

La empresa ha mostrado el primer fruto de esa colaboración en una demostración en video. En ella, el Figure 01 responde a una serie de comandos con acciones específicas. El robot humanoide es capaz de identificar los objetos que tiene al frente y comprende el lenguaje de la persona con la que interactúa.

- CHECALO -

— Figure 01, ¿qué ves ahora?

— Veo una manzana roja sobre un plato al centro de la mesa, un escurridor con platos y vasos y a ti parado cerca con una mano en la mesa

Al solicitarle algo de comer, Figure 01 le da la manzana a la persona y le explica que lo hizo porque es el único comestible que hay en la mesa. Todo esto mientras coloca basura en una caja de plástico. Posteriormente, efectúa un ejercicio de razonamiento al colocar los vasos y platos en el escurridor, seguido de una autoevaluación de su desempeño.

De acuerdo con Brett Adcock, fundador de Figure, el robot Figure 01 ejecuta las acciones por medio de redes neuronales de un extremo a otro. La demostración fue grabada en tiempo real y no existe teleoperación.

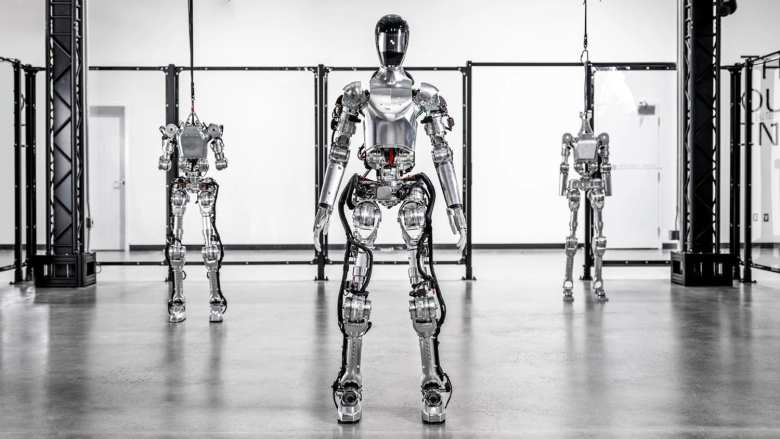

«Las cámaras integradas se alimentan de un modelo grande de lenguaje visual (VLM) entrenado por OpenAI», dijo Adcock. «Las redes neuronales toman imágenes a 10 Hz a través de cámaras en el robot. Luego, la red neuronal genera acciones de 24 grados de libertad a 200 Hz».

Cómo funciona Figure 01, el robot con la IA de OpenAI que responde como un humano

Corey Lynch, director de IA en la empresa, detalló que todos los comportamientos del robot se aprenden y ejecutan a velocidad normal. Lynch, quien también es líder del proyecto Figure 01, reveló que la inteligencia artificial de OpenAI toma las imágenes de las cámaras y transcribe a texto las instrucciones capturadas en audio por los micrófonos del robot.

«El modelo procesa toda la historia de la conversación, incluidas imágenes pasadas, para generar respuestas lingüísticas, que se responden al ser humano a través de texto a voz», dijo Lynch en una publicación en X (Twitter). «El mismo modelo es responsable de decidir qué comportamiento aprendido debe ejecutar en el robot para cumplir un comando determinado, cargar la tarea de las redes neuronales en la GPU y ejecutar una política.»

Lynch explica que el modelo de OpenAI permite que el robot pueda describir su entorno y utilizar el razonamiento con sentido común para tomar decisiones. La inteligencia artificial también le otorga el poder de comprender peticiones ambiguas y actuar en consecuencia. Pero nada de esto sería posible sin la integración de redes neuronales para generar movimientos.

Todos los comportamientos están impulsados por políticas visomotoras de redes neuronales, que asignan píxeles directamente a acciones. Estas redes captan imágenes integradas a 10 Hz y generan acciones de 24 grados de libertad (posturas de muñeca y ángulos de las articulaciones de los dedos) a 200 Hz.

Corey Lynch

En términos generales, el Figure 01 opera del siguiente modo

- El modelo de OpenAI efectúa el razonamiento y diseña un plan

- Las políticas aprendidas de la red neuronal ejecutan el plan por medio de movimientos rápidos y reactivos, apoyándose de un controlador de cuerpo entero para mantener el equilibrio

«Hace algunos años hubiera pensado que tener una conversación con un robot humanoide mientras planifica y lleva a cabo sus propios comportamientos completamente aprendidos sería algo que tendríamos que esperar décadas para ver», dijo Lynch. «Obviamente, muchas cosas han cambiado».

DERECHOS DE AUTOR

Esta información pertenece a su autor original y fue recopilada del sitio https://hipertextual.com/2024/03/robot-openai-future-inteligencia-artificial