Es posible que estés un poco confuso con Apple Intelligence, la presencia de Sam Altman en la WWDC 2024 y todo lo que engloba la nueva IA de los dispositivos de Apple. Tras recuperarse de la resaca de la Keynote, la compañía ha querido explicar cómo funciona su nuevo sistema de inteligencia artificial, que está basado en dos nuevos modelos de lenguaje creados y entrenados desde cero.

Porque no, que algunas funciones de Apple Intelligence estén relacionadas con ChatGPT no significa que su IA utilice los modelos de OpenAI como GPT-4. De hecho, la compañía de Cupertino ni siquiera ha tomado prestado el potencial de este último para crear la base capaz de ofrecer sus funciones basadas en inteligencia artificial.

Una vez esto queda claro, Apple ha profundizado en el hecho de tener dos modelos diferentes para tareas distintas. El primero, es el encargado de ejecutarse dentro de los dispositivos —iPhone, iPad o Mac— y no ‘sale’ al exterior ni se comunica con servidores externos para realizar tareas. Es decir, que todo lo que necesita se lo da el rendimiento de los propios aparatos.

El segundo, hace todo lo contrario. Este se ejecuta en los servidores de la compañía, que por cierto, utilizan miles de chips M2 Ultra para crear un centro de datos masivo. Todas esas funciones de Apple Intelligence que necesitan más capacidad computacional se solucionan de forma externa con un modelo de lenguaje diferente al anterior.

- CHECALO -

De hecho, esta diferencia es una de las pocas que tienen ambos modelos, pues han sido entrenados de la misma forma teniendo en cuenta sus posibilidades. Como puedes imaginar, el modelo que se ejecuta en los dispositivos es mucho menos potente que el otro, aunque los dos siguen reglas muy similares en cuanto a privacidad, datos, gestión de información personal o contenido malicioso.

¿Con qué datos se entrenan los modelos de Apple Intelligence?

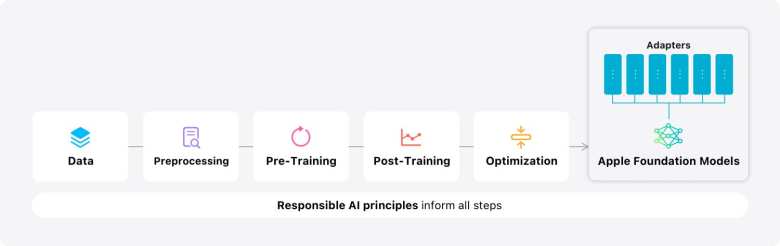

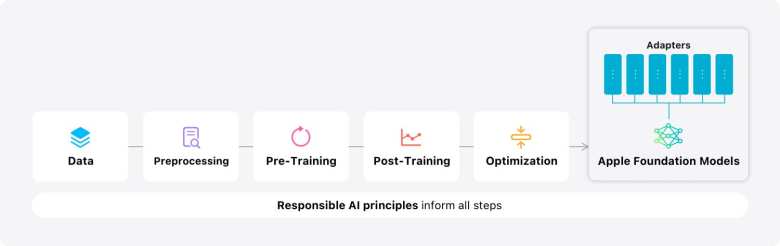

Bien, hay que empezar por el principio. Para poder crear un modelo de lenguaje Apple necesita varias cosas, y entre ellas están los datos. La compañía ha llamado a esta fase ‘Pre-Entrenamiento’ y ha explicado varias cosas fundamentales a tener en cuenta sobre la información que utiliza para dotar de contenido a sus modelos.

Lo más importante es, que Apple no utiliza ningún dato personal ni interacciones privadas en el entrenamiento. Simplemente audita los datos que hay Internet para que no se cuele nada sobre los usuarios. Según la empresa de Cupertino, el volumen de datos es tan masivo que puede acceder a tarjetas de crédito o cuentas de la seguridad social. Pero como ya te hemos dicho, filtra todo este contenido para eliminarlo de su modelo de lenguaje.

Además, en esta fase de recolección de datos también aplican filtros para palabras malintencionadas, información duplicada y se centra en todo lo que se considera contenido de alta calidad.

El post entrenamiento

Con la primera fase terminada, Apple se dio cuenta de que la calidad de los datos era esencial para conseguir un modelo de lenguaje eficiente y con buena escalabilidad para Apple Intelligence, por lo que se puso manos a la obra para crear dos algoritmos que auditasen de nuevo toda la información recolectada y fuesen capaz de curar los datos. Es decir, de pulir todavía todo el contenido que ya sabían los modelos.

La buena noticia es, que ambos algoritmos basan su funcionamiento en el aprendizaje humano y ofrecen capacidades entrenadas por personas, lo que según Apple, se traduce en una mayor calidad de las instrucciones del modelo de lenguaje. Que a su vez, le da a Apple Intelligence más capacidad humana.

Optimización

Una vez que los modelos obtuvieron los datos necesarios y estos fueron auditados al milímetro, llegó la hora de optimizarlos para que su rendimiento fuese lo suficientemente potente. Apple se ha centrado en priorizar la velocidad del primer token, consiguiendo latencia en el iPhone 15 Pro de 0,6 milisegundos. Además, este mismo dispositivo ofrece una tasa de generación de 30 tokens por segundo.

Ambos modelos encargados de mover Apple Intelligence, utilizan consultas agrupadas, lo que reduce la cantidad de memoria y rendimiento bruto y mejora considerablemente la eficiencia.

Adaptación de los modelos a las funciones de Apple Intelligence

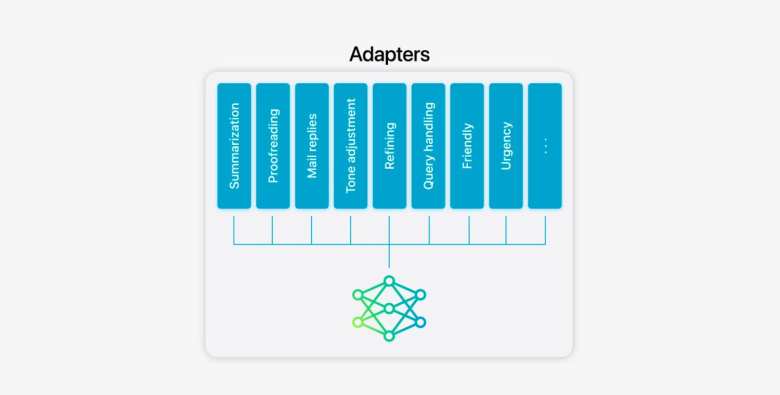

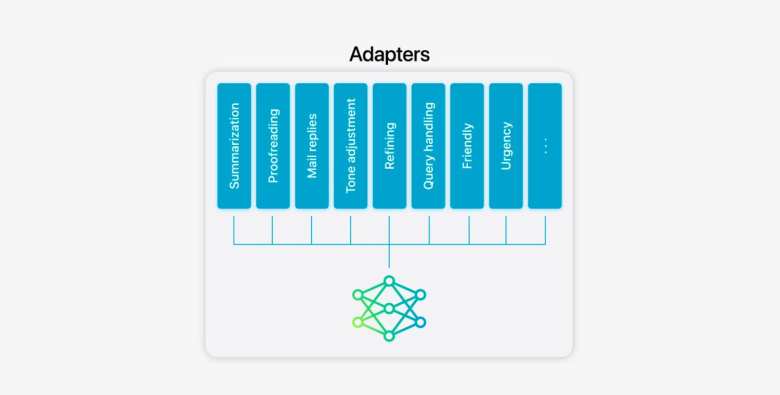

Con el rendimiento optimizado, Apple ha tenido la tarea de ajustar las posibilidades de los dos modelos a las tareas básicas de Apple Intelligence. Y no ha sido fácil, pues la mayoría de compañías abren la puerta a todo, pero cuando la idea es utilizar estos modelos en un iPhone, iPad o Mac, es necesario adaptarlos a las tareas que pueden realizar dichos dispositivos.

Estas adaptaciones permiten a los modelos tener la capacidad de especializarse sobre la marcha en tareas muy específicas como resúmenes de emails o recomendaciones de Siri, además de poder ser escalables de una forma sencilla y eficiente.

En definitiva, han conseguido crear y entrenar dos modelos de lenguaje IA completamente nuevos y con la capacidad de mejorar la forma de expresarse, trabajar y comunicarse a través de los productos de Apple.

DERECHOS DE AUTOR

Esta información pertenece a su autor original y fue recopilada del sitio https://hipertextual.com/2024/06/asi-ha-creado-apple-los-dos-modelos-de-ia-que-impulsan-a-apple-intelligence