A unas semanas de su anuncio, xAI lanzó Grok-1.5V el modelo multimodal de primera generación que ofrece la empresa de Elon Musk. Esta versión es capaz de procesar imágenes y responder preguntas relacionadas. Un SDK de muestra confirmó que la IA multimodal de Elon Musk ya está disponible para los desarrolladores, por lo que pronto podría llegar al público en general.

De acuerdo con la documentación, Grok-1.5V puede comprender documentos, diagramas científicos, cuadros, capturas de pantalla y fotografías. xAI publicó una gráfica con las puntuaciones en diversas pruebas de rendimiento, en donde su inteligencia artificial supera a GPT-4V en algunas tareas como lectura de texto, diagramas, matemáticas o comprensión del mundo real.

«Estamos particularmente entusiasmados con las capacidades de Grok para comprender nuestro mundo físico», mencionó la empresa. «Grok supera a sus pares en nuestro nuevo benchmark RealWorldQA, que mide la comprensión espacial del mundo real», añadió. Este último es un punto de referencia diseñado para evaluar las capacidades básicas de comprensión espacial del mundo en modelos multimodales.

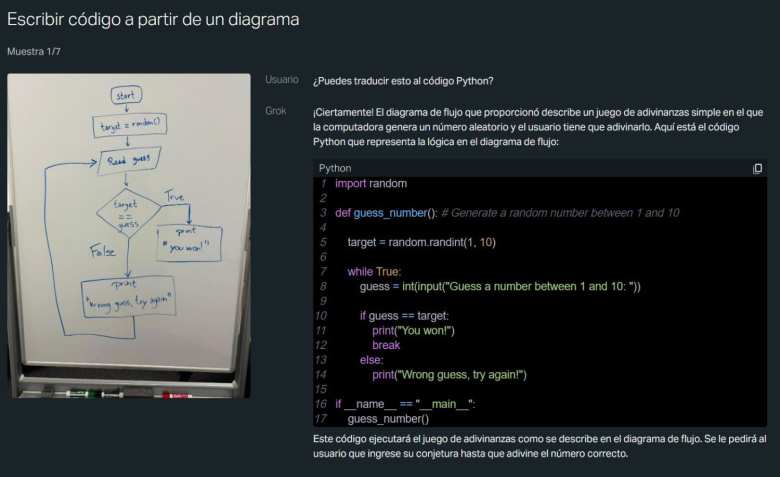

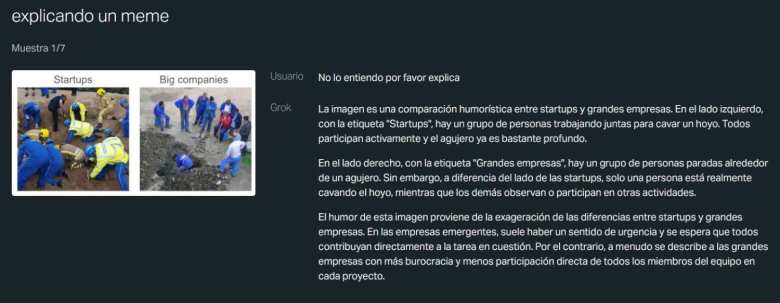

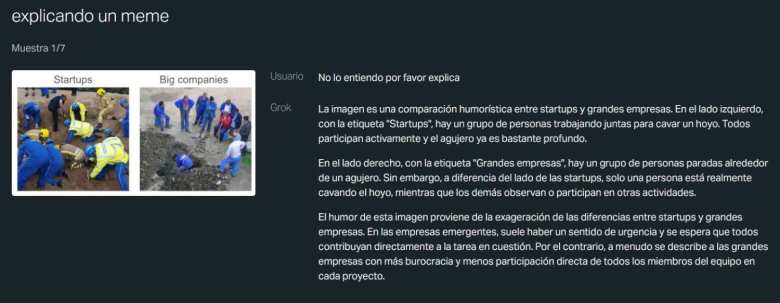

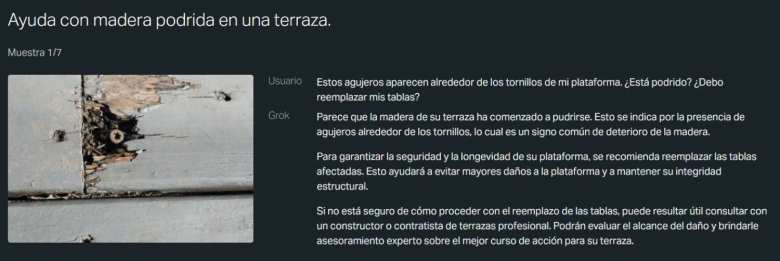

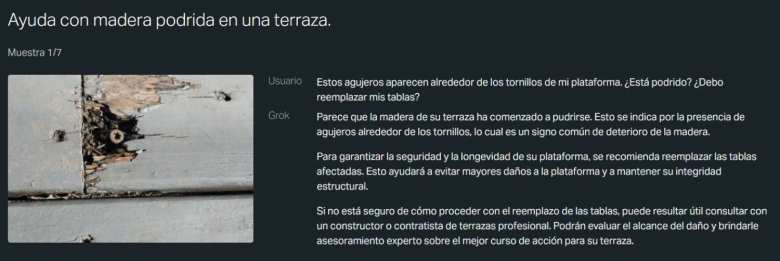

En las primeras pruebas, Grok-1.5V puede reconocer el tamaño y orientación de los objetos, analiza y compara espacios, o identifica texto en las imágenes para responder una pregunta. xAI ha mostrado algunos ejemplos de lo que puede lograr su nuevo modelo multimodal de inteligencia artificial.

- CHECALO -

Grok analiza un diagrama de flujo en una pizarra y lo convierte a código fuente en Python, con todo y comentarios. La IA también identifica una tabla con los valores nutricionales y responde a preguntas específicas sobre calorías. Otro ejemplo se centra en reconocer un bosquejo y escribir un cuento, explicar un meme o analizar una fotografía.

Qué ofrecen los modelos multimodales, como Grok

Un modelo multimodal de IA es un sistema que puede procesar e integrar información de diferentes fuentes como texto, imágenes, audio, video o datos sensoriales. Esto les permite tener una comprensión más completa y contextualizada del mundo que los rodea, similar a los humanos.

A diferencia de los sistemas tradicionales de IA que se enfocan en un solo tipo de datos, como el procesamiento del lenguaje natural para texto o la visión por computadora para imágenes, los modelos multimodales pueden combinar y analizar información de diversas modalidades para efectuar tareas más complejas.

Por ejemplo, un modelo multimodal puede leer una pregunta, analizar una imagen relevante y generar una respuesta que combine texto e imagen. También es capaz de generar subtítulos o descripciones que capturen mejor el contexto y la información no verbal.

La creación de esta clase de modelos requiere grandes cantidades de datos de alta calidad, lo que puede ser un desafío para recopilar y etiquetar. De igual modo, su entrenamiento puede ser computacionalmente intensivo, lo que se necesita garantizar el acceso a hardware potente.

«Avanzar tanto en nuestra comprensión multimodal como en nuestras capacidades de generación son pasos importantes para construir una inteligencia artificial general (AGI) que pueda comprender el universo», declaró xAI. «En los próximos meses, anticipamos realizar mejoras significativas en ambas capacidades, en diversas modalidades, como imágenes, audio y video.»

Grok-1.5V ya está disponible para los desarrolladores. La compañía no reveló cuándo llegará al resto de usuarios, aunque para poder utilizarlo deberás contar con una suscripción Prémium de X (Twitter).

DERECHOS DE AUTOR

Esta información pertenece a su autor original y fue recopilada del sitio https://hipertextual.com/2024/05/grok-ia-elon-musk-multimodal-twitter